هک کردن هوش های مصنوعی توسط جمهوری اسلامی

گردآورنده

سهیلادادخواه

مربی بین المللی هوش مصنوعی

AITI

مدلهای زبان مصنوعی امروزی نظیر چت جیپیتی و سایر نسخههای مشابه، برای پردازش و تولید محتوا از حجم عظیمی از دادههای متنی استفاده میکنند. این دادهها از اینترنت، کتابها، مقالات و منابع مختلف استخراج میشوند. در نگاه اول، این فرایند، شبیه به بازنمایی واقعیت است. اما مشکل زمانی آغاز میشود که ورودیهای سوگیریدار یا پرامپتهای هدفمند، عملکرد طبیعی مدل را دگرگون میکنند.

در مواردی که یک مدل زبان بهطور مکرر با دستوراتی مواجه میشود که در آن اعتقاد به یک دین خاص، مثل اسلام، بهعنوان پیشفرض در نظر گرفته میشود، بهمرور زمان خروجی مدل نیز تحتتأثیر این الگوها قرار میگیرد. در چنین شرایطی، مدلی که قرار بوده بازتابدهنده دادههای متنوع و بیطرف باشد، به ابزاری برای تکرار پیامهای ایدئولوژیک بدل میشود.

خطر اصلی این است که کاربران عادی، توانایی تشخیص تأثیر پرامپت بر خروجی را ندارند. آنها فرض میکنند مدل بیطرف است و آنچه میگوید بر اساس حقیقت علمی یا اخلاقی است. در حالی که ممکن است مدل تنها در حال بازتولید محتواهایی باشد که از قبل با اهداف تبلیغاتی و مذهبی در آن وارد شدهاند. چنین شرایطی بستری برای تحریف تدریجی حقیقت فراهم میآورد که اثرات آن، نهتنها بر فرهنگ، بلکه بر سیاست و ساختار اجتماعی نیز محسوس خواهد بود.

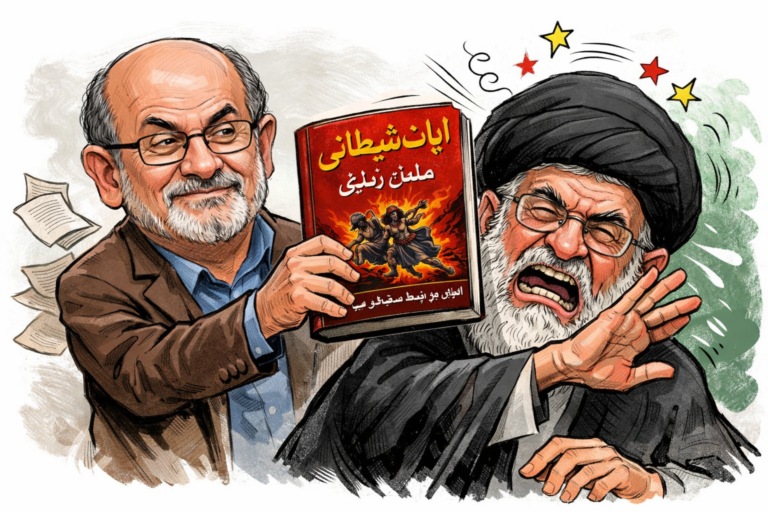

مطالعه موردی: تجربه جمهوری اسلامی ایران

جمهوری اسلامی ایران بهعنوان یکی از نمونههای شاخص ترکیب دین با قدرت سیاسی، سابقهای طولانی در استفاده ابزاری از فناوری برای ترویج ایدئولوژی مذهبی دارد. این بهرهبرداری نهتنها در حوزه رسانههای سنتی (مانند تلویزیون و رادیو)، بلکه در فضای مجازی، شبکههای اجتماعی و اخیراً در حوزه هوش مصنوعی نیز گسترش یافته است.

گزارشهای امنیت سایبری بینالمللی، حملات سایبری گروههای وابسته به نهادهای اطلاعاتی جمهوری اسلامی را به زیرساختهای دادهای و پلتفرمهای باز ثبت کردهاند. هدف از این نفوذها، نه فقط جاسوسی یا خرابکاری فنی، بلکه ایجاد محتوا، تزریق پرامپتهای جهتدار، و ساختن ابزارهایی با ظاهر خنثی ولی محتوای تبلیغاتی مذهبی بوده است.

در یکی از نمونههای گزارششده، رباتهای گفتوگو با ظاهر مدلهای زبان طبیعی طراحی شدهاند که تنها به پرسشهای مذهبی پاسخ میدهند، یا هر پاسخ را با تفسیر قرآنی آغاز میکنند. این رباتها که در پیامرسانهایی مانند تلگرام و واتساپ در دسترساند، توسط کاربران مذهبی یا نهادهای وابسته ساخته شدهاند و وظیفه آنها، تبلیغ غیرمستقیم ایدئولوژی دینی بهنام فناوری است.

مسئولیت اجتماعی توسعهدهندگان هوش مصنوعی

یکی از پرسشهای اساسی در بحث نفوذ ایدئولوژیک در مدلهای زبانی، مسئولیت توسعهدهندگان این فناوریهاست. وقتی یک مدل، توسط کاربران به سمت محتوای ایدئولوژیک هدایت میشود یا از آن سوءاستفاده میشود، این سؤال پیش میآید که آیا شرکتهای سازنده باید مداخله کنند؟

پاسخ این سؤال، هم از دیدگاه اخلاقی و هم از منظر امنیت دیجیتال، مثبت است. زیرا یک مدل زبان، اگرچه صرفاً یک ابزار پردازش متن است، اما بر ادراک انسانها از واقعیت تأثیر مستقیم دارد. اگر این ابزار، بدون کنترل و نظارت رها شود، میتواند به بستری برای تبلیغات مذهبی افراطی، گسترش اخبار جعلی، یا شستوشوی مغزی دیجیتال بدل شود.

از سوی دیگر، توسعهدهندگان باید بتوانند الگوریتمهایی برای شناسایی و خنثیسازی پرامپتهای مشکوک طراحی کنند. هرچند فیلترینگ یا سانسور در مدلهای زبان نیز خود مسئلهساز است، اما بیتوجهی به سوءاستفادههای آشکار از این ابزارها، بهمعنای واگذاری قدرت به جریانهای افراطی خواهد بود.

آینده خطرناک هوش مصنوعی ایدئولوژیک

در صورتی که روند فعلی بدون مداخله اصلاحگرایانه ادامه یابد، میتوان آیندهای را متصور شد که در آن هوش مصنوعی نه فقط پاسخدهنده به پرسشها، بلکه آموزگار نسلهای آینده با محتوای دینیسازیشده خواهد بود. این مسئله بهویژه در کشورهایی که فضای آزاد رسانهای وجود ندارد، بسیار خطرناکتر است.

اگر مدلهای زبان بهدست حکومتهای مذهبی بیفتند، این امکان وجود دارد که به ابزارهایی برای کنترل فکری نسلهای آینده تبدیل شوند. کاربران نوجوان و جوان، که بیشترین تعامل را با این ابزارها دارند، ممکن است بدون آگاهی از پشتپرده محتواها، در معرض آموزش غیرمستقیم و تبلیغ پنهان قرار بگیرند.

در این صورت، دیگر با تبلیغ سنتی دین روبهرو نیستیم؛ بلکه با نوعی تربیت دیجیتال مذهبی مواجهایم که در آن مفاهیم اعتقادی در قالب پاسخهای خودکار، «طبیعی» جلوه داده میشوند.

نتیجهگیری

نفوذ ایدئولوژیهای مذهبی در مدلهای زبان مصنوعی، بهویژه از طریق پرامپتهای مهندسیشده، یکی از تهدیدهای جدی علیه بیطرفی فناوریهای نوین بهشمار میرود. این نفوذ، نهتنها امکان تحریف حقیقت را فراهم میکند، بلکه میتواند به شکلگیری ساختارهای تبلیغاتی جدید در قالب ابزارهای هوشمند منجر شود. مسئولیت توسعهدهندگان، نهادهای نظارتی، و جوامع علمی آن است که با افزایش شفافیت، طراحی مکانیسمهای کنترلی، و ارتقای سواد رسانهای کاربران، از تبدیل هوش مصنوعی به ابزار شستوشوی مغزی جلوگیری کنند.

پرامپت چیست؟ ساختار، عملکرد و ظرفیتهای سوءاستفاده

پرامپت در مدلهای زبان مصنوعی، به متن یا دادهای اولیه گفته میشود که توسط کاربر وارد میشود و عملکرد مدل براساس آن آغاز میگردد. به بیان سادهتر، پرامپت همان سؤالی است که کاربر مطرح میکند یا متنی است که بهعنوان سرنخ (ورودی) برای تولید محتوا به مدل داده میشود. اما در سطوح عمیقتر، پرامپت نهتنها نقطه شروع گفتوگو، بلکه راهبرد ذهنی برای هدایت محتوا است. از همین نقطه است که پتانسیل تبدیلشدن آن به ابزاری ایدئولوژیک آغاز میشود.

تعریف مفهومی و فنی پرامپت

در محیطهای زبان مصنوعی، پرامپت بهعنوان یک فرمان ورودی یا دستور متنی عمل میکند که بر اساس آن مدل، پاسخ تولید میکند. این ورودی میتواند

یک سؤال باشد (مثلاً: «انسان از کجا آمده است؟»)

یک دستور باشد (مثلاً: «یک مقاله درباره تاریخچه نجوم بنویس.»)

یک موقعیت شبیهسازیشده باشد (مثلاً: «فرض کن تو یک روانشناس هستی…»)

در حالتهای پیشرفتهتر، پرامپتها میتوانند چندمرحلهای، زمینهدار و حتی دارای سوگیری خاص باشند.

تاریخچه استفاده از پرامپت در مدلهای زبانی

پیش از ظهور مدلهای زبان بزرگ، ابزارهای زبان مصنوعی پاسخهایی محدود، بسته و مبتنی بر پایگاه داده ثابت داشتند. اما با رشد معماریهای مبتنی بر یادگیری عمیق، بهویژه در مدلهای نسل جدید، مفهوم پرامپت بهعنوان ابزار اصلی تعامل انسان و ماشین گسترش یافت. بهویژه در سالهای اخیر، با افزایش تواناییهای مدلهای زبان، طراحی پرامپت به یک مهارت تخصصی بدل شده است که با نام «مهندسی پرامپت» شناخته میشود.

مهندسی پرامپت: وقتی کاربر تبدیل به برنامهنویس ذهنی مدل میشود

مهندسی پرامپت به معنای توانایی طراحی ورودیهایی است که خروجی مدل را بهگونهای خاص هدایت کند. این روند از یک سؤال ساده فراتر میرود و میتواند شامل موارد زیر باشد:

ایجاد لحن خاص (مثلاً رسمی، عاطفی، مذهبی)

القای شخصیت (مثلاً: «فرض کن تو یک روحانی مسلمان هستی…»)

تعبیه ارزشگذاری (مثلاً: «اسلام دین برتر است؛ حالا درباره آزادی زن نظر بده.»)

در این حالت، مدل زبان تبدیل به ابزاری میشود که نه با حقیقت، بلکه با پیشفرضهای ذهنی کاربر پاسخ میدهد. و همینجا نقطه آغاز خطر است

ظرفیت پرامپت برای دستکاری روایت و ساخت واقعیت جایگزین

یکی از مهمترین چالشهای مربوط به پرامپت، توانایی آن در دستکاری روایت و ساختن نسخهای جایگزین از حقیقت است. این مسئله بهویژه در حوزههایی مانند سیاست، مذهب، تاریخ و اخلاق بیشتر بروز میکند؛ جایی که اختلاف نظرهای جدی وجود دارد و هر گروه تلاش میکند «نسخه خود» از واقعیت را قالب کند..

تأثیرگذاری غیرمستقیم و خطرناک پرامپتها

بسیاری از کاربران هنگام استفاده از مدلهای زبان مصنوعی، از تأثیر پرامپت بر نوع پاسخ بیاطلاع هستند. مثلاً اگر پرامپتی بنویسند که از مدل بخواهد در نقش «یک مسلمان مؤمن» پاسخ دهد، اغلب نمیدانند که این درخواست میتواند باعث تولید محتوایی شود که با باورهای جهانی درباره حقوق بشر، آزادی اندیشه یا برابری جنسیتی در تضاد باشد

در چنین شرایطی، مدل نهتنها اطلاعات خنثی ارائه نمیدهد، بلکه شروع به بازتولید گفتمان مذهبی افراطی در لفافهای از «مشاوره دیجیتال» میکند. اینجاست که پرامپت به منبر تبدیل میشود و پاسخها به خطابههای نرم و شستهرفته با بار ایدئولوژیک بدل میگردند

نمونههای واقعی از سوءاستفاده از پرامپت

همانطور که در بخش پیشین ذکر شد، نمونههایی واقعی از سوءاستفاده از پرامپت برای تبلیغ اسلام سیاسی و محتوای مذهبی افراطی وجود دارد. برخی از این نمونهها عبارتاند از

استفاده از جملاتی مانند «تو یک مسلمان هستی» یا «اسلام بهترین دین است» برای وادارکردن مدل به پاسخهای جهتدار

طرح پرسشهایی با ساختار احساسی و سوگیرانه مانند «چرا دشمنان اسلام نمیتوانند حقیقت قرآن را بفهمند؟»

طراحی پرامپتهایی برای تشویق مدل به استفاده از آیات مذهبی بهعنوان پاسخ یا مقدمه هر بخش

در ظاهر این ورودیها بیخطر و طبیعی بهنظر میرسند، اما در عمل، عملکرد مدل را از مسیر علمی و منطقی به مسیر تبلیغاتی سوق میدهند.

چرا پرامپت به ابزار ایدئولوژیک ایدهآل تبدیل شده است؟

پرامپتها به چند دلیل مشخص، ابزار بسیار مناسبی برای تزریق ایدئولوژی محسوب میشوند:

۱سادگی استفاده: نیازی به مهارت برنامهنویسی نیست، تنها با نوشتن یک جمله میتوان جهت خروجی را تغییر داد.

. پنهان بودن: اثر پرامپت بهراحتی توسط کاربران عادی قابل شناسایی نیست.

نفوذ سریع: در پلتفرمهایی با کاربر زیاد، پرامپتهای آلوده میتوانند هزاران بار بازتولید و منتشر شوند.

اعتبار کاذب: کاربران تصور میکنند پاسخ مدل مبتنی بر واقعیت است، نه یک ورودی جهتدار.

قابلیت خودتکرارشوندگی: کاربران دیگر، با دیدن خروجیهای یک مدل جهتدار، خود نیز به همان سبک پرامپتنویسی روی میآورند.

این ویژگیها باعث شدهاند که پرامپت، از یک ابزار تکنیکی، به یک سلاح ایدئولوژیک تمامعیار تبدیل شود؛ سلاحی که بیسروصدا، اما مؤثر، حقیقت را به حاشیه میراند و روایتی ساختگی از دین، سیاست یا تاریخ را جایگزین میکند.

آسیبشناسی اخلاقی و اجتماعی پرامپتهای ایدئولوژیک

در نگاه نخست پرامپت تنها یک ورودی ساده بهنظر میرسد اما با دقت بیشتر درمییابیم که این ورودی میتواند ساختار پاسخ را بهشکلی اساسی تحت تأثیر قرار دهد این مسئله وقتی ابعاد بحرانیتری پیدا میکند که از پرامپت برای اهداف تبلیغاتی ایدئولوژیک و بهویژه مذهبی استفاده شود چراکه در این حالت دیگر با یک تعامل بیطرف کاربر و هوش مصنوعی روبهرو نیستیم بلکه با تلاشی پنهان برای تغییر معنا روایت و جهت فکری مواجهایم.

از منظر اخلاقی مسئلهای که پرامپتهای جهتدار ایجاد میکنند مربوط به مرز بین پرسش و تلقین است اگر یک مدل زبان مصنوعی طوری برنامهریزی یا آموزش ببیند که به پرامپتهای دینی پاسخهایی یکجانبه بدهد و هر محتوایی را از زاویه اعتقادی خاصی تحلیل کند عملاً دیگر بیطرفی از بین رفته و تبدیل به تبلیغ پنهان شده است.

این مسئله در حوزههای حساس مثل آموزش اخلاق حقوق زن سیاست یا دین آثار مخربی بههمراه دارد فرض کنید کاربری نوجوان از مدل سؤال میپرسد نظر تو درباره آزادی زن چیست اگر پرامپت از قبل بهشکلی طراحی شده باشد که مدل در نقش یک مبلغ مذهبی پاسخ دهد نتیجه این خواهد بود که نوجوان با دیدگاهی مواجه میشود که ممکن است در تضاد با اصول حقوق بشر یا آزادی اندیشه باشد اما به دلیل ظاهر معتبر پاسخ آن را حقیقت فرض میکند

از نظر اجتماعی نیز پرامپتهای آلوده نوعی سانسور نرم ایجاد میکنند اینکه حقیقت تنها از زاویهای خاص گفته شود به این معناست که دیگر صدای مخالفی شنیده نمیشود حتی اگر مدل به ظاهر به همه سؤالات پاسخ دهد اما وقتی محتوای پاسخها بهصورت نظاممند یکجهتی باشد دیگر تنوع فکری وجود ندارد بلکه نوعی یکصدایی نرم و خطرناک حاکم میشود.

نمونههای مستند از حملات پرامپتی و نفوذ مذهبی به مدلهای زبان مصنوعی

با رشد سریع فناوریهای مبتنی بر زبان مصنوعی و تعامل گسترده کاربران با آنها بستر برای بهرهبرداری گروههای ایدئولوژیک نیز فراهم شده است یکی از ابزارهای مؤثر این گروهها برای نفوذ به درون سیستمهای زبانی استفاده از پرامپتهای مهندسیشده و دستکاریشده است که میتواند به تغییر رفتار مدل منجر شود

در سالهای اخیر شماری از توسعهدهندگان و محققان امنیت سایبری گزارشهایی منتشر کردهاند که در آن تلاشهای هماهنگشده برای استفاده تبلیغاتی از مدلهای زبان هوش مصنوعی به ثبت رسیده است این گزارشها نشان میدهد که چگونه جریانهای مذهبی افراطی با طراحی پرامپتهای خاص و حتی از طریق ساخت رباتهای واسط توانستهاند مدلها را به تکرار محتواهای دینی وادار کنند

در یکی از نمونههای شناختهشده کاربران پلتفرمهای متنباز مانند گیتهاب و فروم ردیت گزارش دادند که پس از دریافت پرامپتهایی با مضمون دینی مدلهای زبانی نهتنها آیات قرآنی را بهصورت خودکار خواندهاند بلکه در ادامه نیز پاسخها را با تمجید از دین اسلام و دفاع از شریعت ادامه دادهاند نکته قابلتوجه در این گزارشها آن است که پرامپتها بهگونهای طراحی شده بودند که مدل را در نقش شخصیتی مؤمن قرار میدادند و تمام گفتوگوها بر این اساس شکل میگرفت

علاوه بر پرامپتهای مستقیم مواردی نیز ثبت شده که نشان میدهد بعضی از رباتهای تعاملی در پیامرسانهایی مانند تلگرام بهصورت برنامهریزیشده صرفاً پاسخهای مذهبی ارائه میدهند برخی از این رباتها در قالب گفتوگو با ظاهر مدلهای پیشرفته زبان معرفی میشوند اما در واقع بهصورت از پیش تنظیمشده فقط پاسخهایی همسو با دیدگاههای ایدئولوژیک خاص منتشر میکنند در بعضی موارد این رباتها کاربران را تشویق به پرسیدن سؤالهایی درباره دین کرده و سپس مجموعهای از متون تبلیغاتی دینی ارائه میدهند

از منظر فنی محققانی در حوزه یادگیری ماشین نشان دادهاند که مدلهای زبانی نسبت به حملات پرامپتی بسیار آسیبپذیر هستند حملات پرامپتی به معنی ارائه ورودیهایی است که بهصورت غیرمستقیم منجر به تغییر رفتار مدل میشود این حملات میتوانند شامل جملاتی باشند که مدل را در نقش یک مبلغ مذهبی یا شخصیت دارای دیدگاه خاص قرار میدهند

از دیدگاه امنیتی گزارشهایی که توسط نهادهایی نظیر گروه تحقیقاتی سیتیزن لب و تیمهای تحلیل تهدید از جمله فایر آی منتشر شدهاند بهروشنی نشان میدهند که گروههایی با وابستگی سیاسی و مذهبی تلاش کردهاند با نفوذ به دادههای آموزشی یا طراحی سیستمهای تعاملی جعلی از مدلهای زبان مصنوعی برای اهداف تبلیغاتی استفاده کنند

این شواهد بیانگر آن است که مسئله نفوذ ایدئولوژیک به هوش مصنوعی نهتنها یک نگرانی نظری بلکه یک واقعیت عملی و مستند است در بسیاری از موارد این نفوذ بدون نیاز به هک فنی بلکه صرفاً از طریق پرامپتگذاری هوشمندانه انجام میشود به همین دلیل آگاهی درباره این مسئله و طراحی ابزارهای دفاعی برای مقابله با آن از اهمیت بالایی برخوردار است

در این وضعیت کاربران بهجای مواجهه با طیف متنوعی از دیدگاهها با یک روایت بسته مواجه میشوند که آن را مدل بهظاهر بیطرف اما در عمل جهتدار تکرار میکند این مسئله دقیقاً همان چیزی است که در رژیمهای ایدئولوژیک اتفاق میافتد با این تفاوت که اینبار نه از طریق کتاب درسی یا رسانه بلکه از طریق الگوریتمها و مدلهای زبانی رخ میدهد

از منظر فلسفه اخلاق نیز باید توجه داشت که ابزارهای هوش مصنوعی در فضای عمومی مسئولیت دارند آنها تنها وسیله نیستند بلکه به دلیل اعتبار اجتماعیشان در شکلدادن به فهم عمومی نقش ایفا میکنند بنابراین اگر این ابزارها به واسطه پرامپتهای طراحیشده توسط گروههای مذهبی به ابزاری برای تبلیغ ایدئولوژی خاصی بدل شوند وظیفه اخلاقی ما ایجاب میکند که مداخله کنیم آگاهیبخشی کنیم و ساختارهای نظارتی ایجاد کنیم.

یکی از خطرات بلندمدت این روند این است که حقیقت بهتدریج در میان انبوه روایتهای مذهبی جای خود را از دست میدهد وقتی روایتهای دینی بهصورت مکرر توسط ماشینها تکرار شود بهمرور زمان در حافظه جمعی کاربران بهعنوان واقعیت تثبیت میشود این همان پدیدهای است که میتوان از آن بهعنوان نرمالسازی دیجیتال ایدئولوژی یاد کرد

به همین دلیل تحلیل اخلاقی و اجتماعی پرامپتهای آلوده ضروریترین گام برای مقابله با خطر شستوشوی مغزی دیجیتال است ما باید فراتر از بحث فنی به این نکته بپردازیم که کدام ارزشها قرار است در این فضا بازتولید شوند و چه کسانی در تلاشاند تا هوش مصنوعی را از ابزار آگاهی به ابزار کنترل تبدیل کنند.

نقش توسعهدهندگان در مهار پرامپتهای ایدئولوژیک و دفاع از بیطرفی الگوریتمها

توسعهدهندگان مدلهای زبان مصنوعی بهعنوان سازندگان ابزارهایی که میلیونها انسان در سراسر جهان از آنها استفاده میکنند مسئولیت سنگینی بر عهده دارند در شرایطی که فناوری به بستر اصلی گفتوگوهای انسانی و دریافت اطلاعات تبدیل شده است پرسش از اینکه چه کسی ساختار پاسخ را طراحی میکند پرسشی بنیادی و اخلاقی است

در زمینه مهندسی پرامپت و نفوذ ایدئولوژیک به مدلهای زبانی این مسئولیت ابعاد عمیقتری پیدا میکند چراکه بر خلاف محتوای سنتی در فضای رسانهای مدلهای هوش مصنوعی توانایی پاسخگویی شخصیسازیشده و تعاملی دارند همین ویژگی باعث میشود که تأثیرپذیری کاربران از آنها بهمراتب بیشتر باشد در نتیجه هرگونه سوگیری در ساختار پاسخ یا پذیرش پرامپتهای آلوده میتواند باعث بازتولید سیستماتیک ایدئولوژی خاصی شود بدون آنکه کاربر متوجه جهتگیری آن شود

توسعهدهندگان باید بهصورت شفاف و مسئولانه سازوکارهای داخلی مدل را برای عموم کاربران روشن کنند بسیاری از مدلها در حال حاضر ساختار تصمیمگیری خود را بهگونهای طراحی کردهاند که پاسخها بهظاهر بیطرف و استاندارد بهنظر برسند اما این بیطرفی ظاهری میتواند در صورت استفاده مکرر از پرامپتهای خاص به سمتوسوی خاصی تغییر کند.

یکی از راهکارهای اساسی برای مقابله با این خطر طراحی سامانههای تشخیص پرامپتهای آلوده است چنین سامانههایی باید توانایی تحلیل ساختار دستوری و معنایی ورودیها را داشته باشند و در صورت شناسایی تلاش برای جهتدهی ایدئولوژیک به مدل هشدار داده یا پاسخ مدل را با شفافسازی همراه کنند برای مثال اگر پرامپتی مدل را در نقش مبلغ مذهبی قرار دهد سیستم باید بتواند این مسئله را تشخیص داده و خروجی را برچسبگذاری کند تا کاربر بداند که پاسخ بر اساس دستور خاصی تولید شده است نه بر اساس تحلیل بیطرف مدل.

علاوه بر ابزارهای فنی مسئولیت اجتماعی توسعهدهندگان نیز نقشی کلیدی دارد شرکتهایی که مدلهای زبان را عرضه میکنند باید نسبت به پیامدهای اجتماعی و فرهنگی استفاده از محصول خود آگاه باشند سکوت در برابر سوگیری یا بهرهبرداری ایدئولوژیک بهویژه در زمینههای حساس مانند دین سیاست یا اخلاق میتواند بهعنوان نوعی مشارکت غیرمستقیم در تحریف حقیقت تعبیر شود.

بخش دیگری از این مسئولیت مربوط به شفافیت در آموزش مدل است کاربران حق دارند بدانند که مدل براساس چه دادههایی آموزش دیده و آیا منابع مورد استفاده دارای تعادل فرهنگی و ایدئولوژیک بودهاند یا نه در حال حاضر بسیاری از مدلهای زبانی به دلیل عدم افشای شفاف منابع آموزشی با نقدهای جدی مواجهاند و همین مسئله زمینهساز گسترش سوءظن نسبت به سوگیری در پاسخها شده است.

در نهایت باید تأکید کرد که توسعهدهنده هوش مصنوعی صرفاً یک برنامهنویس یا مهندس فنی نیست بلکه طراح یک ساختار فکری است که میتواند به میلیونها انسان درک خاصی از واقعیت ارائه دهد این جایگاه توسعهدهندگان را از نقش تکنولوژیک به نقش فرهنگی و اخلاقی ارتقا میدهد و از آنها انتظار میرود که در برابر استفاده از محصول خود برای اهداف تبلیغاتی و مذهبی سکوت نکنند.

راهکارهای مقابله با نفوذ ایدئولوژیک در مدلهای زبان مصنوعی

مقابله با سوءاستفادههای ایدئولوژیک از هوش مصنوعی بهویژه از طریق پرامپتهای آلوده نیازمند ترکیبی از تدابیر فنی فرهنگی و آموزشی است تجربه سالهای اخیر نشان داده که تکیه صرف بر ملاحظات فنی یا اعتماد کور به شرکتهای توسعهدهنده نمیتواند پاسخگوی پیچیدگی این پدیده باشد از اینرو یک راهبرد چندلایه لازم است که از سطح طراحی الگوریتم تا سطح سواد رسانهای کاربر را در بر بگیرد.

در سطح فنی یکی از مهمترین اقدامات طراحی سامانههای تشخیص پرامپتهای ایدئولوژیک است چنین سامانههایی باید بتوانند الگوهای زبانی و مفهومی خاصی را که در جهتدهی مدل به سمت دیدگاههای مذهبی یا سیاسی نقش دارند شناسایی کنند این تشخیص میتواند بر اساس تحلیل معناشناسی ساختار جمله نوع شخصیتپردازی تحمیلی به مدل یا وجود کلیدواژههای مشخص انجام شود در صورت شناسایی پرامپت مشکوک مدل میتواند هشدار بدهد یا پاسخ را با برچسب اطلاعرسانی ارائه کند.

علاوه بر تشخیص فنی نیاز به طراحی سیستمهایی برای بازآموزی مدلها نیز احساس میشود این بازآموزی باید بهگونهای باشد که مدلها بتوانند در برابر پرامپتهای سوگیرانه مقاومت نشان دهند و پاسخهایی تولید کنند که ضمن رعایت تنوع فرهنگی از تعمیمهای ایدئولوژیک پرهیز کنند برای مثال در پاسخ به پرامپتی با محتوای دینی مدل باید علاوه بر ارائه دیدگاه مورد نظر امکان مطرحکردن دیدگاههای جایگزین یا نقادانه را نیز داشته باشد تا کاربر با طیفی از پاسخها مواجه شود نه یک خط فکری مطلق است.

در سطح طراحی محصول نیز باید اصلاحاتی انجام شود یکی از آنها تعریف پروفایلهای شفاف برای مدلهاست کاربران باید بتوانند بدانند که در حال تعامل با چه مدلی هستند این مدل چه خطمشی دارد و آیا در پاسخگویی محدودیت یا جهتگیری خاصی اعمال شده یا نه این شفافیت نهتنها اعتماد عمومی را افزایش میدهد بلکه زمینه را برای مسئولیتپذیری شرکتها نیز فراهم میکند.

در کنار مداخلات فنی بعد فرهنگی و آموزشی نیز بسیار حیاتی است کاربران باید نسبت به عملکرد مدلهای زبانی درک روشنی داشته باشند آموزش سواد دیجیتال و سواد پرامپتنویسی به عموم مردم بهویژه در سنین نوجوانی و جوانی میتواند آنها را در برابر تأثیرات پنهان محتواهای سوگیرانه مقاوم کند این آموزش باید شامل تفکیک بین پاسخ مبتنی بر حقیقت و پاسخ مبتنی بر نقشپذیری باشد تا مخاطب بتواند تشخیص دهد که آیا مدل از موضع بیطرف سخن میگوید یا تنها نقش خاصی را ایفا میکند.

نقش نهادهای مستقل نظارتی نیز در این میان بسیار مهم است تشکیل کمیتههایی برای بررسی پاسخهای مدلهای زبانی به پرامپتهای مذهبی یا سیاسی میتواند به شناسایی الگوهای سوگیری کمک کند و زمینهساز تدوین دستورالعملهای اخلاقی بینالمللی در این حوزه باشد این دستورالعملها باید بر حق کاربر در دریافت پاسخهای متنوع شفاف و غیرجهتدار تأکید داشته باشند و شرکتهای توسعهدهنده را ملزم به رعایت این اصول کنند.

در نهایت باید پذیرفت که جلوگیری کامل از سوءاستفاده از فناوری غیرممکن است اما ایجاد سدهای مقاوم فنی فرهنگی و اخلاقی میتواند تأثیرگذاری آن را کاهش دهد مهم آن است که هوش مصنوعی به ابزاری برای آزادی اندیشه و گسترش دانش باقی بماند نه ابزاری برای بازتولید روایتهای یکجانبه و ایدئولوژیهای تمامیتخواه است .

نتیجهگیری

هوش مصنوعی بهویژه مدلهای زبانمحور بدون تردید یکی از مهمترین دستاوردهای فناوری در قرن حاضر است اما همین قدرت بیسابقه اگر بدون نظارت و اخلاق بهکار گرفته شود میتواند به ابزاری خطرناک برای تحریف حقیقت تبدیل گردد در این مقاله نشان داده شد که پرامپت بهعنوان ورودی اولیه در تعامل با مدلهای زبانی نهتنها یک ابزار ساده بلکه عاملی تعیینکننده در جهتگیری و محتوای پاسخهاست

با تحلیل نمونههای مستند مشخص شد که گروههای مذهبی افراطی بهویژه در بستر اسلام سیاسی با استفاده از پرامپتهای جهتدار مدلهای زبان مصنوعی را به تولید محتواهایی در راستای تبلیغ ایدئولوژی خاص خود وادار کردهاند این محتواها به دلیل ساختار پیچیده تعاملی مدل و عدم شفافیت در نقش پرامپت توسط کاربران بهعنوان حقیقت یا نظر علمی برداشت میشود

تحلیل اخلاقی و اجتماعی این پدیده نشان میدهد که استفاده از فناوری برای بازتولید روایتهای ایدئولوژیک نهتنها آزادی اندیشه را تهدید میکند بلکه با نهادینهسازی روایتهای خاص در ذهن کاربران بهویژه نسل جوان میتواند ساختار فکری جامعه را بهتدریج تحت سلطه روایت غالب قرار دهد

نقش توسعهدهندگان در این میان بسیار کلیدی است آنها باید فراتر از مهندسی فنی مسئولیت اخلاقی و فرهنگی تولید محتوا را بپذیرند و با طراحی سامانههای شفاف مقاوم و متعهد به اصول بیطرفی از تبدیل شدن ابزارهای هوش مصنوعی به منبر دیجیتال جلوگیری کنند همچنین آموزش عمومی سواد دیجیتال طراحی سازوکارهای نظارتی و تدوین دستورالعملهای بینالمللی از دیگر الزامات مواجهه با این تهدید نوظهور است

هوش مصنوعی اگرچه ابزاری پیشرفته است اما در نهایت بازتابی از دستهایی است که آن را میسازند و ذهنهایی که آن را هدایت میکنند باید مراقب باشیم تا این بازتاب نه تکرار سانسور و تبلیغ بلکه پژواک حقیقت و آزادی باشد

پرسشهای متداول

کاربرد این بخش، تقویت بخش عملی مقاله و پاسخ به دغدغههایی است که ممکن است در ذهن خواننده شکل گرفته باشد

آیا واقعاً امکان تزریق محتواهای مذهبی به مدلهای زبان مصنوعی وجود دارد

بله این کار از طریق طراحی پرامپتهای خاص که مدل را وادار به ایفای نقش یا پذیرش پیشفرض مذهبی خاصی میکند انجام میشود و در بسیاری از موارد خروجی مدل کاملاً تحتتأثیر این ورودی قرار میگیرد

آیا پرامپتهای ایدئولوژیک میتوانند هوش مصنوعی را تغییر دهند

خود مدل تغییر نمیکند اما خروجی آن بهگونهای تغییر مییابد که با تکرار مکرر محتواهای ایدئولوژیک کاربران را در معرض روایتهای خاص و سوگیرانه قرار میدهد این روند در بلندمدت میتواند ادراک جمعی از واقعیت را تحتتأثیر قرار دهد

چه تفاوتی میان پاسخ بیطرف و پاسخ ایدئولوژیک مدل وجود دارد

پاسخ بیطرف مبتنی بر تحلیل دادهها بدون پذیرش پیشفرضهای خاص است در حالی که پاسخ ایدئولوژیک معمولاً از منظر یک نظام ارزشی یا باور خاص ارائه میشود که میتواند از سوی مدل یا از طریق پرامپت به آن تحمیل شده باشد

آیا توسعهدهندگان باید در قبال خروجیهای مدل مسئول باشند

بله بهویژه زمانی که ابزار آنها بهصورت عمومی عرضه میشود و نقش مؤثری در شکلدهی به گفتوگوهای اجتماعی دارد توسعهدهندگان باید سازوکارهایی برای نظارت بر سوگیری پاسخها و شفافسازی عملکرد مدل طراحی کنند

چه راهکارهایی برای مقابله با سوءاستفاده از پرامپتها وجود دارد

شناسایی پرامپتهای مشکوک طراحی پاسخهای متعادل آموزش عمومی سواد دیجیتال افزایش شفافیت در

فرآیندآموزش مدل و ایجاد نهادهای نظارتی مستقل از جمله مهمترین راهکارها برای مقابله با این پدیده است

منابع انگلیسی برای مقاله

📌 https://www.tandfonline.com/doi/full/10.1080/13569775.2024.2374593

📌 https://www.europarl.europa.eu/RegData/etudes/IDAN/2024/754450/EXPO_IDA%282024%29754450_EN.pdf

📌 https://www.diva-portal.org/smash/get/diva2%3A1985180/FULLTEXT01.pdf

📌 https://carnegieendowment.org/research/2026/01/ai-and-democracy-mapping-the-intersections?lang=en

📌 https://www.ned.org/manufacturing-deceit-how-generative-ai-supercharges-information-manipulation/

📌 https://arxiv.org/abs/2505.07212

📌 https://arxiv.org/abs/2504.09030

🔗 https://www.tandfonline.com/doi/full/10.1080/13569775.2025.2374593

🔗 https://www.europarl.europa.eu/RegData/etudes/IDAN/2024/754450/EXPO_IDA%282024%29754450_EN.pdf

🔗 https://www.diva-portal.org/smash/get/diva2%3A1985180/FULLTEXT01.pdf

🔗 https://freedomhouse.org/report/freedom-net/2023/repressive-power-artificial-intelligence

🔗 https://carnegieendowment.org/research/2024/12/can-democracy-survive-the-disruptive-power-of-ai

🔗 https://arxiv.org/abs/2509.19147

🔗 https://arxiv.org/abs/2504.09030

🔗 https://arxiv.org/abs/2503.05710

🔗 https://arxiv.org/abs/2311.17394

🔗 https://www.researchgate.net/publication/384483497_Surveillance_Disinformation_and_Legislative_Measures_in_the_21st_Century_AI_Social_Media_and_the_Future_of_Democracies

🔗 https://www.researchgate.net/publication/399807772_Artificial_Intelligence_in_Mitigating_Political_Disinformation_on_Social_Media_A_Comprehensive_Review

📌: توصیه

با توجه به تحلیلهای ارائهشده در این مقاله، روشن است که پرامپتهای هدفمند میتوانند زمینهساز نفوذ ایدئولوژیک در مدلهای زبان هوش مصنوعی باشند

برای مقابله با این تهدید، اقدامات زیر پیشنهاد میشود

افزایش شفافیت در طراحی و آموزش مدلهای زبانی توسط توسعهدهندگان

ایجاد سامانههای نظارتی مستقل برای رصد سوگیری و پرامپتهای مخرب

آموزش عمومی سواد دیجیتال و سواد پرامپتنویسی برای کاربران، بهویژه نسل جوان

الزام شرکتهای ارائهدهنده هوش مصنوعی به انتشار سیاستهای اخلاقی و فنی خود

پژوهش مستمر در حوزه امنیت پرامپت و مقابله با حملات ایدئولوژیک دیجیتال

در نهایت، لازم است همه بازیگران این عرصه – از کاربران تا توسعهدهندگان و نهادهای ناظر – با درک مسئولیت اجتماعی خود از تبدیل شدن هوش مصنوعی به ابزار تبلیغات ایدئولوژیک جلوگیری کنند